활성화 함수란?

인공 신경망에서 뉴런이 입력 신호의 가중합을 받아들였을 때 그 출력을 어떻게 변환할지를 결정하는 함수이다.

단순한 합계를 그대로 전달하지 않고 특정 규칙에 따라 비선형적으로 변환해줌으로써 복잡한 패턴 학습을 가능하게 해준다.

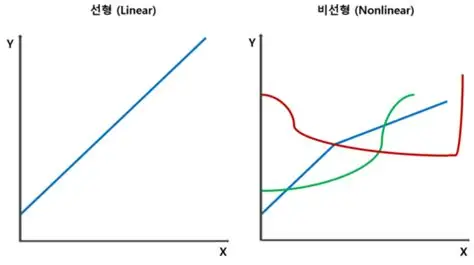

선형 vs 비선형

인공지능에서 데이터는 선형과 비선형으로 나뉜다.

머신러닝은 선형 데이터를 다룰 수 있지만 비선형 데이터는 다루지 못한다.

딥러닝은 비선형 데이터를 다룰 수 있다.

선형 데이터

입력 변수와 출력 변수 사이의 관계과 직선으로 표현 가능한 데이터

선형 함수

단순한 일차 함수가 아니라 복잡한 곡선 함수도 선형 함수라고 볼 수 있다.

비선형 데이터

입력 변수와 출력 변수의 관계가 직선으로 표현되지 않는 데이터

선형 모델의 목적은 대개 추정하거나 해석을 할 때 사용

비선형 모델은 복잡한 패턴을 갖는 데이터에서 예측할 때 사용

비선형 활성화 함수 덕분에 신경망은 "복잡한 함수 근사"가 가능해짐.

활성화 함수 종류

- Sigmoid(Logistic)

- Tanh(Hyperbolic tangent)

- ReLU(Rectified Linear Unit)

- Leaky ReLU, PReLU

- Softmax

과대 적합

모델이 학습 데이터에 너무 과하게 맞춰져서 테스트 데이터에서는 성능이 떨어지는 상태

학습 데이터에는 성능이 높지만, 새로운 데이터에 일반화가 안됨

과소 적합

모델이 학습 데이터의 패턴을 충분히 학습하지 못한 상태

훈련 데이터와 테스트 데이터 모두에서 성능이 낮음

과대적합 vs 과소적합

과대적합 특징:

학습 정확도 높음

검증 정확도 낮음

훈련 데이터의 노이즈까지 학습해버림

과소적합 특징:

학습 정확도 낮음

검증 정확도 낮음

모델이 너무 단순하거나, 학습이 충분히 안되었을 때 발생

과대적합 원인:

모델이 너무 복잡

학습 데이터 부족

정규화 부족

데이터 노이즈에 과민 반응

과소적합 원인:

모델이 너무 단순

학습 데이터 부족

학습 epoch/iteration 부족

피처 부족

과대적합 해결 방법:

모델 복잡도 줄이기

정규화 사용

학습 데이터 증가/데이터 증강

Early stopping

과소적합 해결 방법:

모델 복잡도 증가

학습 데이터 증가

학습 epoch 늘리기

더 좋은 특징 사용